Apache Dubbo 有injvm方式的通信,能够避免网络带来的延迟,同时也不占用本地端口,对测试、本地验证而言,是一种比较方便的RPC通信方式。

最近看到 containerd 的代码,发现它也有类似的需求。

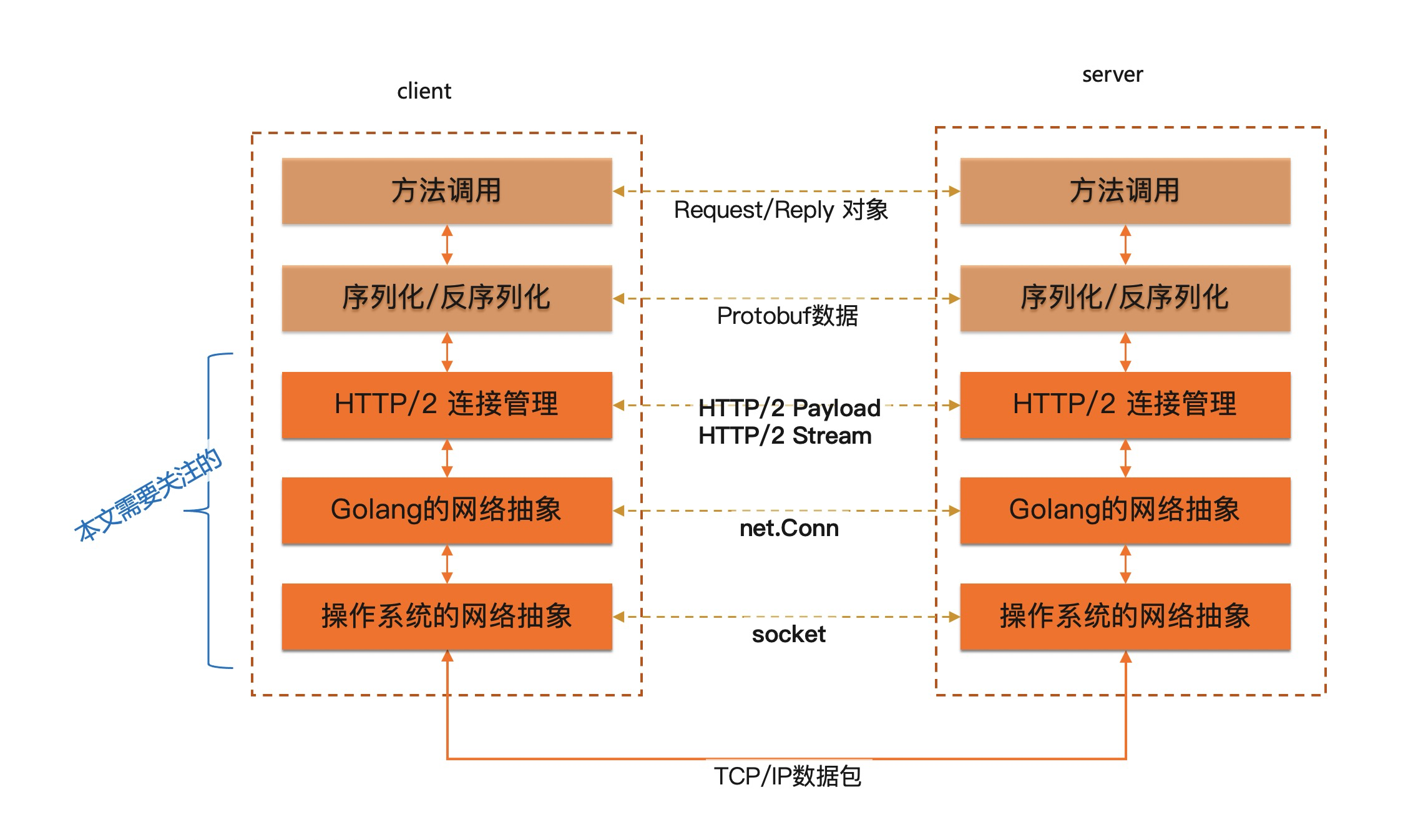

Golang/gRPC对网络的抽象 首先,我们先看一下gRPC一次调用的架构图。当然,这个架构图目前只关注了网络抽象分布。

我们重点关注网络部分。

操作系统系统抽象 首先,在网络包之上,系统抽象出来了socket ,代表一条虚拟连接,对于UDP,这个虚拟连接是不可靠的,对于TCP,这个链接是尽力可靠的。

对于网络编程而言,仅仅有连接是不够的,还需要告诉开发者如何创建、关闭连接。对于服务端 ,系统提供了accept方法对于客户端 ,系统提供了connect方法

Golang抽象 在Golang中,socket对等的概念叫net.Conn

接下来,对于服务端,accept这个行为被包装成了net.Listener接口net.Dial方法

1 2 3 4 5 6 type Listener interface {error )error

gRPC使用 那么gRPC是怎么使用Listener和Dial的呢?

对于gRPC服务端,Serve方法

对于gRPC客户端,网络本质上就是一个能够连接到某个地方的东西就可以,所以只需要一个dialer func(context.Context, string) (net.Conn, error)函数就行了。

什么是pipe 在操作系统层面,pipe

Golang也基于pipe提供了net.Pipe()函数

但是net.Pipe仅仅产生了两个net.Conn,即只产生两个网络连接,没有之前提到的Listner,也没有Dial方法。

于是结合Golang的channel,把net.Pipe包装成了Listner,也提供了Dial方法:

Listener.Accept(),只需要监听一个channel,客户端连接过来的时候,把连接通过channel传递过来即可Dial方法,调用Pipe,将一端通过channel给服务端(作为服务端连接),另一端作为客户端连接

代码如下:

pipe_listener.go 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 package mainimport ("context" "errors" "net" "sync" "sync/atomic" var ErrPipeListenerClosed = errors.New(`pipe listener already closed` )type PipeListener struct {chan net.Connclose chan struct {}uint32 func ListenPipe () return &PipeListener{make (chan net.Conn),close : make (chan struct {}),func (l *PipeListener) error ) {select {case c = <-l.ch:case <-l.close :return func (l *PipeListener) error ) {if atomic.LoadUint32(&l.done) == 0 {defer l.m.Unlock()if l.done == 0 {defer atomic.StoreUint32(&l.done, 1 )close (l.close )return return func (l *PipeListener) return pipeAddr(0 )func (l *PipeListener) string ) (net.Conn, error ) {return l.DialContext(context.Background(), network, addr)func (l *PipeListener) string ) (conn net.Conn, e error ) {if atomic.LoadUint32(&l.done) != 0 {return select {case <-ctx.Done():case l.ch <- c0:case <-l.close :return type pipeAddr int func (pipeAddr) string {return `pipe` func (pipeAddr) string {return `pipe`

如何用pipe作为gRPC的connection 有了上面的包装,我们就可以基于此创建一个gRPC的服务器端和客户端,来进行基于内存的RPC通信了。

首先,我们简单的创建一个服务,包含了四种调用方式:

helloworld/helloworld.proto 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 syntax = "proto3" ;option go_package = "google.golang.org/grpc/examples/helloworld/helloworld" ;option java_multiple_files = true ;option java_package = "io.grpc.examples.helloworld" ;option java_outer_classname = "HelloWorldProto" ;package helloworld;service Greeter {rpc SayHello(HelloRequest) returns (HelloReply) rpc SayHelloReplyStream(HelloRequest) returns (stream HelloReply)rpc SayHelloRequestStream(stream HelloRequest) returns (HelloReply)rpc SayHelloBiStream(stream HelloRequest) returns (stream HelloReply)message HelloRequest {string name = 1 ;message HelloReply {string message = 1 ;

然后生成相关的stub代码:

1 2 3 protoc --go_out=. --go_opt=paths=source_relative \

然后开始写服务端代码,基本逻辑就是实现一个demo版本的服务端就好:

server.go 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 package mainimport ("context" "log" "github.com/robberphex/grpc-in-memory/helloworld" "github.com/robberphex/grpc-in-memory/helloworld" type server struct {func (s *server) error ) {"Received: %v" , in.GetName())return &pb.HelloReply{Message: "Hello " + in.GetName()}, nil func (s *server) error {if err != nil {"error receiving: %v" , err)return err"Received: %v" , req.GetName())if err != nil {"error receiving: %v" , err)return err"Received: %v" , req.GetName())"Hello " + req.GetName()})return nil func (s *server) error {"Received: %v" , req.GetName())"Hello " + req.GetName()})if err != nil {"error Send: %+v" , err)return err"Hello " + req.GetName() + "_dup" })if err != nil {"error Send: %+v" , err)return errreturn nil func (s *server) error {if err != nil {"error receiving: %+v" , err)return err"Received: %v" , req.GetName())"Hello " + req.GetName()})if err != nil {"error Send: %+v" , err)return errreturn nil func NewServerImpl () return &server{}

然后我们创建一个基于pipe连接的客户端来调用服务端。

包含如下几个步骤:

创建服务端实现

基于pipe创建listener,然后基于它创建gRPC server

基于pipe创建客户端连接,然后创建gRPC client,调用服务

代码如下:

client.go 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 package mainimport ("context" "fmt" "log" "net" "github.com/robberphex/grpc-in-memory/helloworld" "google.golang.org/grpc" func serverToClient (svc *server) if err := s.Serve(pipe); err != nil {"failed to serve: %v" , err)`pipe` ,func (c context.Context, s string ) error ) {return pipe.DialContext(c, `pipe` , s)if err != nil {"did not connect: %v" , err)return cfunc main () for i := 0 ; i < 5 ; i++ {"world_unary_%d" , i)})if err != nil {"could not greet: %v" , err)"Greeting: %s" , r.GetMessage())for i := 0 ; i < 5 ; i++ {if err != nil {"could not SayHelloRequestStream: %v" , err)"SayHelloRequestStream_%d" , i)})if err != nil {"could not Send: %v" , err)"SayHelloRequestStream_%d_dup" , i)})if err != nil {"could not Send: %v" , err)if err != nil {"could not Recv: %v" , err)for i := 0 ; i < 5 ; i++ {"SayHelloReplyStream_%d" , i)})if err != nil {"could not SayHelloReplyStream: %v" , err)if err != nil {"could not Recv: %v" , err)if err != nil {"could not Recv: %v" , err)for i := 0 ; i < 5 ; i++ {if err != nil {"could not SayHelloStream: %v" , err)"world_stream_%d" , i)})if err != nil {"could not Send: %v" , err)if err != nil {"could not Recv: %v" , err)

总结 当然,作为基于内存的RPC调用,还可以有更好的方式,比如直接将对象传递到服务端,直接通过本地调用方式来通信。

本文介绍的,基于Pipe的通信方式,除了网络层走了内存传递之外,其他都和正常RPC通信行为一致,比如同样经历了序列化、经历了HTTP/2的流控制等。当然,性能上比原生调用也会差一点,但是好在对于测试、验证场景,行为上的一致比较重要些。

本文代码已经托管到了GitHub https://github.com/robberphex/grpc-in-memory 。